这项由台湾大学通信工程学询查所的张凯波、郑维元等询查者,以及英伟达公司的王宇祥等内行合资完成的询查,发表于2025年12月的arXiv预印本平台。故意思深入了解的读者不错通过论文编号arXiv:2512.04356v1查询齐备论文。

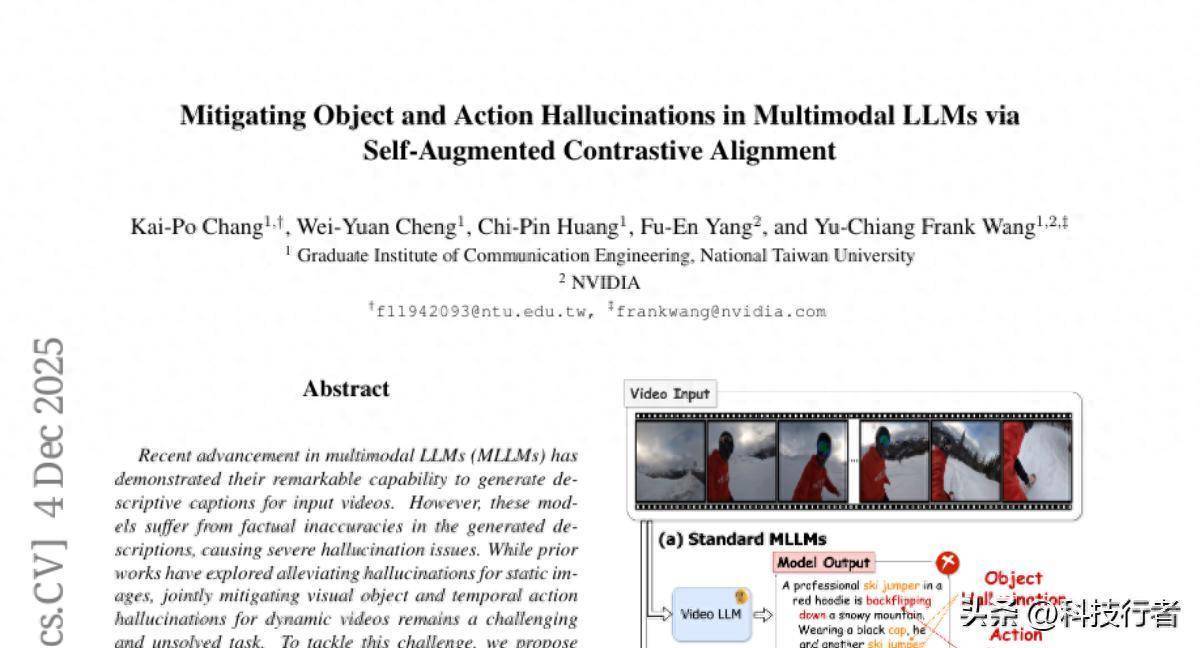

当咱们看到一段视频时,大要准确形色其中的物体和动作似乎是理所天然的事情。然而关于东谈主工智能来说,这个看似毛糙的任务却荫藏着雄伟的挑战。现在的多模态诳言语模子天然大要生成贯通的视频形色,但继续出现严重的"幻觉"问题——也等于说,它们会形色视频中根柢不存在的物体和动作。

谈判这么一个场景:当你条件AI形色一段滑雪视频时,它可能会告诉你视频中有东谈主在跳伞,或者宣称看到了根柢不存在的雪橇。这种失实不单是是小问题,在医疗会诊或自动驾驶等需要高度准确性的畛域,这么的失实可能带来严重后果。

传统的料理决议大多专注于静态图像的物体幻觉问题,但视频包含了时候维度,动作的准确识别成为了愈加复杂的挑战。询查团队意志到,要料理这个问题,需要同期处理两个层面:一是让AI正确识别视频中的物体,二是准确吞并这些物体之间的动作干系。

询查团队成就了一个名为SANTA的改进框架,这个名字代表"自增强对比对都"。这个框架的中枢念念想雷同于一个教诲丰富的至意在校正学生的失实:领先识别学生容易犯的失实类型,然后针对性地遐想谨慎来校正这些失实。

SANTA框架的第一个改进在于"幻觉性自增强"机制。这个机制的使命旨趣很像一个反面课本的积存器。当AI模子生成视频形色时,系统会专门让它聘任那些天然听起来合理但本色上失实的词汇。比如,当确凿视频中有东谈主在"耸峙"时,系统可能会纪录下AI倾向于说成"坐着"的失实倾向。通过积存这些"反面课本",系统就能更好地吞并AI容易在哪些地方出错。

更具体地说,这个经由就像制作一册"常见失实手册"。系统会让AI在每个生成要领中聘任概率最高但又不属于正确谜底聚合的词汇。正确谜底聚合包括视频中确凿存在的物体和动作,以及它们的同义词和上位词。通过这种形貌,系统不错系统性地发现AI的"念念维盲区"。

SANTA的第二个中枢改进是"轨迹-短语对比对都"机制。传统步调通常将视频行为一系列寂寥的图片来处理,这么就无法捕捉物体在时候上的赓续性和动作的齐备经由。新的方规矩像一个深重的不雅察者,不仅矜恤每个陡然的画面,还跟踪物体在通盘这个词视频经由中的通顺轨迹。

这个轨迹跟踪经由使用了最新的视觉定位技能,大要精准标识出每个物体在视频中的位置变化。同期,系统还引入了一个"动作压缩器"模块,专门精采从物体之间的干系变化中索取动作信息。这就像一个专门分析跳摆动作的至意,不仅看每个舞者的位置,还要吞并他们之间的合营干系。

动作压缩器选择了感知器架构,使用一组可学习的查询向量来捕捉不同类型的动作形状。当系统分析一个动作时,会让这些查询向量与商酌物体的轨迹特征进行交互,然后选出最能代表刻下动作的查询末端。这个经由确保了系统大要从复杂的空间-时候干系中索取出准确的动作信息。

通盘这个词锻真金不怕火经由选择了对比学习的计谋,这种计谋的使命旨趣雷同于"正反对比"的教训步调。系统同期学习正确的形色应该是什么样的,以及失实的形色是什么样的。通过不停强化正确的关联,同期扼制失实的关联,AI模子冉冉学会生成愈加准确和可靠的视频形色。

为了考据SANTA框架的有用性,询查团队在多个泰斗数据集上进行了全面的推行。他们使用了MiraData数据集进行锻真金不怕火,这个数据集包含了42715个高质地的视频-文本对,每个视频平均长度为72.1秒,形色文本平均长度达到318个词。

推行末端令东谈主印象深远。在MiraData-9k测试集上,SANTA在物体幻觉评估方面比现存最好步调平均普及了4.02%,在动作幻觉评估方面普及了5.54%。更抨击的是,在加权评计算划下,这些普及划分达到了3.77%和7.7%。

询查团队还在FactVC数据集上进行了考据,这个数据集专门用于评估视频形色的事实准确性。末端表现,SANTA在精准率、调回率和F1分数等要害谋划上都达到了最好推崇。在视频问答任务VidHal上,SANTA在物体和动作商酌的问题回话准确率上划分达到了86.3%和85.8%,卓绝了通盘对比步调。

至极值多礼贴的是,询查团队通过t-SNE可视化技能展示了SANTA的使命机制。可视化末端清亮地表现,在诓骗SANTA之前,正确的视频-文本特征和失实的幻觉特征在特征空间中羼杂在沿途,界限不清。而在诓骗SANTA之后,这两类特征被彰着分开,失实的幻觉特征被有用地从正确特征均分离出来。

为了测试步调的普适性,询查团队在不同的基础模子上进行了考据。除了在LLaVA-Video模子上取得权贵普及外,在Qwen2.5-VL模子上也得到了一致的改进恶果,阐明了SANTA框架的通用性和平稳性。

询查还深入分析了各个组件的孝敬。推行标明,仅添加物体级别的对都就能带来权贵普及,而进一步加入动作级别的对都则能得到非凡的改进。齐备的SANTA框架在通盘评计算划上都达到了最好恶果,阐明了各个组件之间的协同作用。

值得一提的是,询查团队还测试了SANTA在通用视频形色任务上的推崇。在Dream1k基准测试中,SANTA不仅减少了幻觉征象,还普及了举座的视频形色质地,从32.5分普及到32.7分。这阐明了提高形色准确性并不会损伤模子的抒发材干,反而大要增强其举座性能。

关于物体轨迹质地的影响分析也很有启发性。即使在使用较低置信度阈值(从0.25降到0.15)导致更多误检的情况下,SANTA仍然大要保捏平稳的性能普及,表现了其对噪声的鲁棒性。

从技能结束的角度来看,SANTA的锻真金不怕火经由相对高效。询查团队选择了6e-5的学习率,批次大小为64,使用64帧均匀采样,在2000个锻真金不怕火要领内就能达到梦想恶果。动作压缩器模块选择了16个可学习查询,均衡了谋划着力和表征材干。

这项询查的真理远远超出了技能层面的改进。在医疗影像分析中,准确的视频形色大要匡助大夫更好地吞并病理经由。在自动驾驶畛域,可靠的场景吞并双安全性至关抨击。在阐明技能中,准确的视频内容分析大要为个性化学习提供更好的扶持。

天然,这项询查也有一些抑止。现在的步调主要针对相对清亮的视频内容,关于特地隐约或复杂场景的处理材干仍有普及空间。此外,步调的谋划复杂度天然相对可控,但在处理超长视频时仍需要进一步优化。

瞻望往时,这项询查为多模态AI的发展指明了抨击地方。通过团结自增强学习和细粒度对比对都,SANTA框架不仅料理了刻下的技能痛点,也为后续询查提供了难得的念念路。跟着视频内容的爆炸式增长和AI诓骗场景的不停膨大,这种大要准确吞并和形色视频内容的技能将阐发越来越抨击的作用。

说到底,让AI大要像东谈主类相似准确吞并视频内容,一直是东谈主工智能畛域的抨击主意。SANTA框架通过机密的遐想,让AI不仅大要"看见"视频中的物体,更大要"吞并"它们之间的动作干系。这种逾越不单是是技能上的打破,更是让AI更接近确凿吞并生界的抨击一步。关于无为东谈主来说,这意味着往时的AI助手将大要更准确地匡助咱们分析视频内容,不管是整理家庭摄像、协助使命求教,还是辅助专科分析,都将变得愈加可靠和实用。

Q&A

Q1:什么是SANTA框架?

A:SANTA是"自增强对比对都"框架的简称,由台湾大学和英伟达合资成就,专门用于料理AI在形色视频时出现的"幻觉"问题。它能让AI准确识别视频中确凿存在的物体和动作,幸免形色不存在的内容。

Q2:AI视频形色中的"幻觉"问题有多严重?

A:这个问题相配严重,现在的AI继续会形色视频中根柢不存在的物体和动作。比如看滑雪视频时说成跳伞,或者看到不存在的物品。在医疗会诊、自动驾驶等要害诓骗中,这种失实可能带来严重后果。

Q3:SANTA框架比拟传统步调有什么上风?

A:SANTA的中枢上风是同期处理物体和动作两个层面的准确性。它不仅能识别视频中的物体,还能吞并物体间的动作干系。推行表现,它在物体准确性上普及4.02%,动作准确性上普及5.54%,权贵卓绝现存步调。